Trwa kampania społeczna „NGO bez barier” w ramach projektu pt. „Lubelscy Liderzy Dostępności”, sfinansowanego przez Narodowy Instytut Wolności – Centrum Rozwoju Społeczeństwa Obywatelskiego ze środków Programu Fundusz Inicjatyw Obywatelskich NOWEFIO na lata 2021–2030. Projekt jest realizowany przez Związek Stowarzyszeń Forum Lubelskich Organizacji Pozarządowych. Celem projektu jest wzmocnienie pod względem strategicznym rozwoju Lubelskiego Partnerstwa na Rzecz Dostępności (LPnRD), które jest płaszczyzną współpracy na rzecz zapewnienia dostępności osobom ze szczególnymi potrzebami w woj. lubelskim.

To nie technologia AI powinna likwidować bariery za człowieka

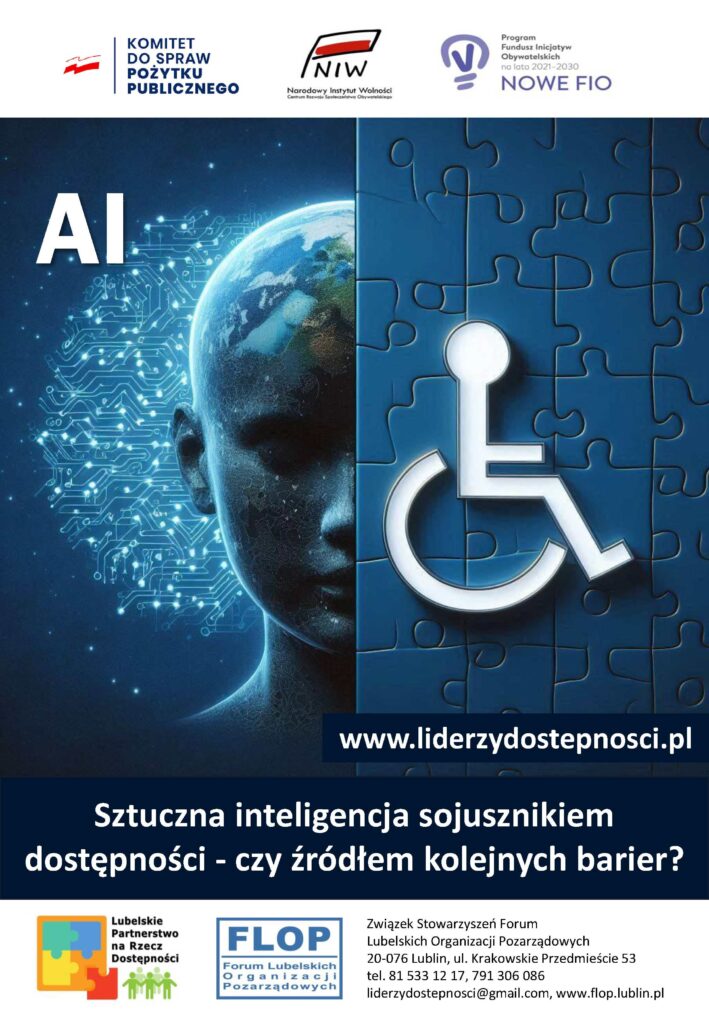

Rewolucja technologiczna AI przez jednych jest witana z zachwytem, zaś przez innych z dużą obawą. Czy słusznie? Rzeczywistość trzeba kształtować świadomie – nie każda innowacja będzie postępem. Automatyzacja to nie sztuczna inteligencja. Potrzebna jest refleksja – dla kogo została stworzona sztuczna inteligencja? Czy przypadkiem nie pogłębi barier – zamiast je redukować? Ufajmy technologii AI – ale jednocześnie „patrzmy jej na ręce”. Automatyzacja ma sens tylko wtedy, gdy wspiera proces – zamiast go zastępować.

Technologia AI widzi bariery – ale to ludzie powinni mieć możliwość podejmowania ostatecznej decyzji jak je likwidować. Chodzi o to, aby AI nie zabierała im niezależności i swobody wyboru. I żebyśmy to my, jako społeczeństwo, mówili technologii, gdzie ma być użyteczna – a nie odwrotnie. Twórcy AI powinni zrozumieć, że człowiek potrzebuje nowoczesne technologie – ale jako pomocnicze narzędzia. W przeciwnym wypadku maszyny przejmą pełną kontrolę i dadzą ludziom „dostęp do prądu”, ale bez możliwości „zarządzania elektrownią”. Problemy mogą zacząć się pojawiać wtedy, gdy zbyt mocno zaufamy AI i przestaniemy ją kontrolować. Człowiek uzależni się od AI – choć będzie przekonany, że to on w pełni panuje nad wszystkim. Dlatego ważne jest, aby AI stał się sprzymierzeńcem człowieka w rozwoju dostępności – a nie kolejną barierą.

Jednak nie każda technologia będzie neutralna dla człowieka. To technologia AI ma służyć ludziom – a nie ich całkowicie wyręczać. Powinniśmy uczyć się na błędach z przeszłości oraz starać nie popełniać ich w przyszłości. Algorytm jest niezależny od wykonawcy. Dlatego technologię AI należy traktować jako partnera do współpracy – a nie drogę na skróty. Nowa technologia tylko przetwarza dane. To my musimy nauczyć ją empatii – poprzez projektowanie z udziałem osób, które tych rozwiązań naprawdę potrzebują. Dlatego jednym z istotnych problemów do rozwiązania jest niedostateczna reprezentacja osób z niepełnosprawnościami w procesie tworzenia i testowania narzędzi AI.

Ufaj, ale sprawdzaj

I choć technologia AI potrafi być potężnym sprzymierzeńcem człowieka w budowaniu świata bez barier – to nie jest magiczną różdżką. AI uczy się na podstawie dostępnych danych – a dane mogą być zawodne. Choć możliwości są ogromne, to AI nie jest wolne od błędów. Algorytmy mogą powielać stereotypy, błędnie rozpoznawać potrzeby użytkowników albo działać nieskutecznie w sytuacjach niestandardowych. Korzystając z narzędzi AI, należy mieć świadomość występowania tzw. halucynacji, czyli wiarygodnie brzmiących fałszywych informacji. AI nie przyzna się, że nie zna prawidłowej odpowiedzi – zamiast tego będzie konfabulować. Dlatego w przypadku AI należy stosować zasadę „ufaj, ale sprawdzaj”.

AI może wprawdzie pomóc zidentyfikować bariery, ale nie rozwiąże ich bez udziału człowieka. Rozwiązania dotyczące dostępności nie powstają w serwerowniach. Ograniczenia technologii często prowadzą do błędów, które mogą utrudniać życie użytkownikom. Pod tym względem algorytmy uczą się na danych, które nie zawsze odzwierciedlają różnorodność potrzeb i stylów życia różnych grup społecznych. Przykładowo jeżeli AI nauczy się, że odbiorcami Internetu są tylko młodzi i pełnosprawni użytkownicy – to kogo pominie w przyszłości? Kogo nie zauważy? Przed kim znowu zostaną zamknięte drzwi?

Automatyczne napisy – choć coraz lepsze, wciąż sprawiają trudności w rozpoznawaniu kontekstu, specyfiki mowy niewyraźnej czy specjalistycznego branżowego słownictwa. Kolejny poważny problem to zagrożenie prywatności. Osoby z niepełnosprawnościami mogą być szczególnie narażone na ryzyko naruszenia ich prywatności podczas korzystania z narzędzi AI. To może rodzić poważne obawy etyczne dotyczące ochrony wrażliwych danych osobowych użytkowników Internetu. Podobnie opisy wygenerowane przez AI mogą zawierać błędy, przez co treść będzie trudna do zrozumienia. Nieczytelna też może okazać się transkrypcja rozmowy osoby jąkającej się, czy wypowiedź osoby z silnym obcym akcentem. Ponadto tłumaczenie tekstu pisanego na język migowy może nie uwzględniać wszystkich niuansów, jak też kulturowego znaczenia przekazu. Stąd jeszcze technologia AI nie potrafi w pełni zastąpić człowieka, który z życzliwością – zareaguje, zapyta i pomoże osobom ze szczególnymi potrzebami. Pod tym względem sztuczna inteligencja jest szybka, ale nie zawsze wrażliwa i czuła.

Dostępność wymaga nie tylko wydajności, ale też zrozumienia i empatii. Stąd maszyna nigdy nie zastąpi rozmowy żywego człowieka z osobą z niepełnosprawnością. W tym zakresie potrzebne są osobiste relacje człowieka z drugim człowiekiem, gdzie technologia ma być służyć pomocą – a nie tworzyć dodatkowej bariery. Na podobnej zasadzie automatyczne narzędzia nie zastąpią audytu dostępności wykonanego przez doświadczonych ekspertów, w tym z udziałem testerów będących osobami z niepełnosprawnościami. Audyt dostępności wykonany przez człowieka nie tylko wskaże rozpoznane bariery – ale też będzie zawierać mapę drogową naprawy. Nowoczesna technologia AI to wciąż tylko narzędzie – najważniejsi są ludzie.

Więcej na: www.liderzydostepnosci.pl/ngo-bez-barier/